JetBrains AI

Supercharge your tools with AI-powered features inside many JetBrains products

JetBrains AI Assistant 2024.3 : bénéficiez d’une meilleure expérience avec l’IA grâce à la sélection de modèles, à la saisie semi-automatique de code optimisée, et bien plus

JetBrains AI Assistant 2024.3 est là ! L’un des points clés de cette nouvelle version réside dans la possibilité de choisir votre modèle de chat. Vous pouvez maintenant opter pour Google Gemini, OpenAI ou des modèles locaux, afin d’adapter les interactions et de profiter d’une expérience encore plus personnalisée.

Cette mise à jour apporte également la saisie semi-automatique du code pour les principaux langages de programmation, une meilleure gestion du contexte et la possibilité de générer des prompts inline directement dans l’éditeur.

Davantage de contrôle sur votre expérience avec le chat : choisissez entre Gemini, OpenAI ou des modèles locaux

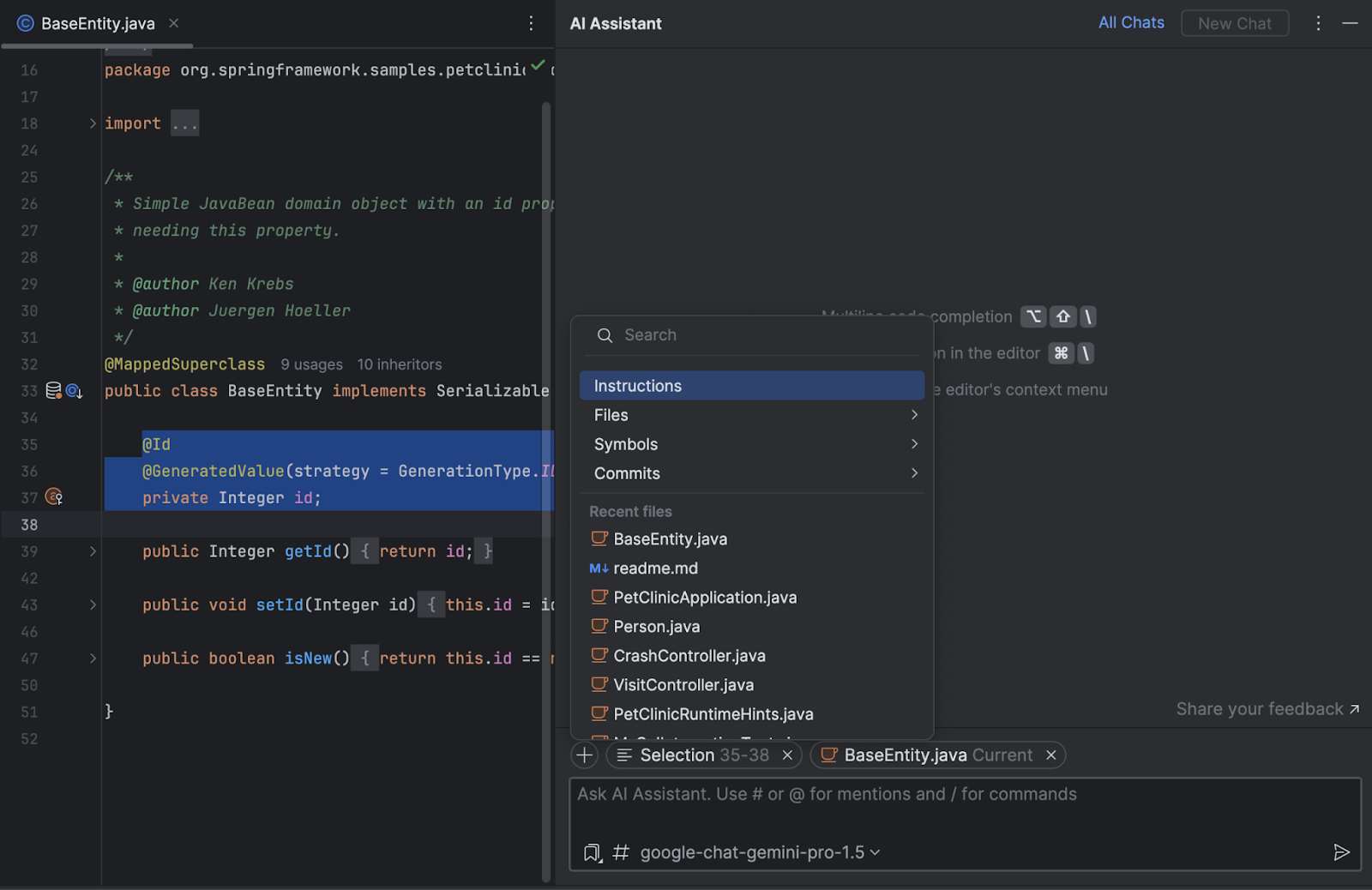

Vous pouvez désormais sélectionner votre modèle de chat par IA, qu’il s’agisse de prestataires cloud comme Google Gemini et OpenAI, ou de modèles locaux. Cette sélection étendue vous permet de personnaliser les réponses du chat en fonction des spécificités de votre workflow et de bénéficier d’une expérience plus flexible et adaptée.

Disponibilité des modèles Gemini de Google

L’offre des LLM utilisés par JetBrains AI inclut maintenant Gemini 1.5 Pro 002 et Flash 002. Ces modèles sont conçus pour offrir des fonctionnalités de raisonnement avancées et des performances optimisées pour de nombreux types de tâches. La version Pro excelle pour les applications complexes, tandis que Flash est plus adaptée pour les scénarios à fort volume et faible latence. Les utilisateurs de l’AI Assistant peuvent maintenant s’appuyer sur la puissance des modèles Gemini, ainsi que sur Mellum, le modèle propriétaire de JetBrains, et sur OpenAI.

Prise en charge du modèle local via Ollama

En plus des modèles basés sur le cloud, vous pouvez connecter le chat par IA aux modèles locaux disponibles via Ollama afin d’offrir davantage de confidentialité, de flexibilité et la possibilité d’exécuter les modèles sur du matériel local, ce qui est particulièrement utile pour les utilisateurs qui souhaitent avoir plus de contrôle sur leurs modèles d’IA.

Pour ajouter un modèle Ollama au chat, vous devez activer la prise en charge d’Ollama dans les paramètres de l’AI Assistant et configurer la connexion à votre instance Ollama.

Gestion du contexte améliorée

Avec cette mise à jour, nous avons rendu le traitement du contexte dans l’AI Assistant plus transparent et intuitif. L’interface utilisateur remaniée vous permet d’afficher et de gérer chaque élément inclus en tant que contexte, pour une visibilité et un contrôle complets. Le fichier ouvert et tout le code sélectionné qu’il contient sont désormais automatiquement ajoutés au contexte, et vous pouvez facilement ajouter ou supprimer des fichiers selon vos besoins afin d’adapter le contexte à votre workflow. Vous pouvez en outre joindre des instructions à l’échelle du projet pour que vos instructions concernant les réponses de l’AI Assistant soient respectées dans toute votre base de code.

Saisie semi-automatique du code cloud avec prise en charge de langages étendue

JetBrains a lancé son propre grand modèle de langage (LLM), Mellum, qui est spécifiquement conçu pour améliorer la saisie semi-automatique du code basée sur le cloud pour les développeurs. Ce nouveau modèle, spécialisé dans les tâches de programmation, a étendu la prise en charge à plusieurs nouveaux langages, parmi lesquels JavaScript, TypeScript, HTML, C#, C, C++, Go, PHP et Ruby. La saisie semi-automatique du code est maintenant unifiée pour tous les JetBrains IDEs, et offre la mise en évidence des éléments de syntaxe pour le code suggéré, davantage de flexibilité pour l’acceptation des suggestions jeton par jeton ou ligne par ligne, et une réduction globale de la latence.

Améliorations pour la saisie semi-automatique du code : prise en charge multiligne pour Python et optimisation de la prise en compte du contexte

La saisie semi-automatique du code locale a été considérablement améliorée et fournit désormais des suggestions multilignes pour Python. Ces optimisations concernent aussi d’autres langages. Pour Kotlin, la génération augmentée de récupération (RAG) permet au modèle d’extraire des informations provenant de plusieurs fichiers d’un projet, afin de générer les suggestions les plus pertinentes possibles. La prise en charge de JavaScript, de TypeScript et de CSS a également permis d’améliorer la fonctionnalité RAG existante. De plus, la saisie semi-automatique du code locale a été introduite pour le code HTML.

Ces améliorations permettent un affichage des suggestions plus rapide pour tous les langages, offrant ainsi une expérience encore plus fluide. La saisie semi-automatique du code locale est incluse gratuitement dans votre IDE, ce qui vous permet de profiter immédiatement de ces fonctionnalités.

Expérience simplifiée dans l’éditeur avec les prompts d’IA inline

La nouvelle fonctionnalité de prompt d’IA inline de l’AI Assistant introduit un moyen de saisir directement vos prompts dans l’éditeur. Commencez simplement la saisie de votre requête en langage naturel et l’AI Assistant saura l’interpréter et générer une suggestion. Les prompts d’IA inline prennent en compte le contexte et incluent automatiquement les fichiers et symboles associés, pour une génération de code plus précise. Cette fonctionnalité est disponible via un abonnement à l’AI Assistant et prend en charge les formats de fichiers Java, Kotlin, Scala, Groovy, JavaScript, TypeScript, Python, JSON, YAML, PHP, Ruby et Go.

Nous avons également amélioré la visibilité des modifications appliquées. Une marque de couleur violette apparaît maintenant dans la gouttière à côté des lignes modifiées par l’AI Assistant, afin que vous puissiez facilement voir ce qui a été mis à jour.

Simplification des mises à jour multiples dans un fichier

L’AI Assistant fournit maintenant la génération de code dans l’ensemble d’un fichier, ce qui simplifie la réalisation de modifications. Cette fonctionnalité permet de modifier de multiples sections de code, notamment pour ajouter les importations nécessaires, mettre à jour les références et définir les déclarations manquantes. Elle est actuellement disponible pour Java et Kotlin et se déclenche via l’action Generate Code si aucune sélection spécifique n’est faite dans l’éditeur. Vous bénéficiez ainsi d’une expérience fluide pour effectuer des ajustements au niveau de tout un fichier.

Obtention de réponses instantanées sur les fonctionnalités et les paramètres de l’IDE dans le chat par IA

Fini les recherches fastidieuses dans les paramètres et la documentation ! La nouvelle commande /docs permet d’accéder à des réponses basées sur la documentation directement dans le chat par IA. Posez simplement une question sur une fonctionnalité à l’AI Assistant et il vous fournira des instructions interactives étape par étape.

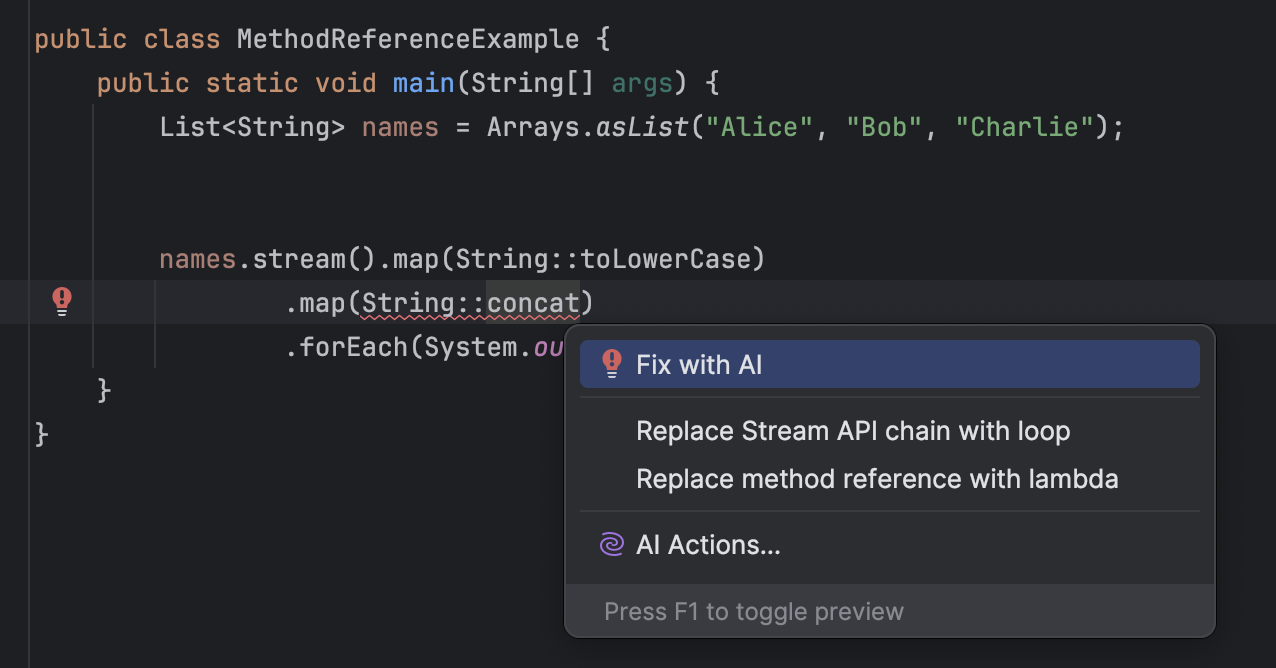

Correctifs générés par l’IA pour une résolution plus rapide des erreurs

Lorsqu’une inspection d’un JetBrains IDE signale un problème, qu’il s’agisse d’une erreur de syntaxe, d’une importation manquante ou autre, elle propose un correctif rapide directement dans l’éditeur. La dernière mise à jour, Fix with AI, va encore plus loin. Cette nouvelle fonctionnalité s’appuie sur la prise en compte du contexte par l’IA pour suggérer des correctifs plus précis et adaptés à votre contexte, ce qui aide à résoudre les problèmes de code plus rapidement et facilement, sans aucune intervention manuelle.

Essayez l’AI Assistant et partagez vos retours d’expérience

Explorez ces mises à jour et laissez l’AI Assistant simplifier encore plus votre workflow. Comme toujours, nous avons hâte de recevoir vos retours d’expérience ! Vous pouvez nous en faire part via le lien Share your feedback dans la fenêtre d’outil de l’AI Assistant ou nous transmettre vos demandes de fonctionnalités ou signalements de bug dans YouTrack.

Bon développement !

Auteur de l’article original en anglais :

Subscribe to JetBrains AI Blog updates